Related articles

简述 hudi,重度依赖spark做了一套table format的设计和文件管理,解决批流存储统一的问题。所有元数据,如果不依赖metastore都是放在文件中(它自身设计了一个简单的metastore在1.0版本,当前主要与hive metastore结合可以做湖仓,虽然不是必须项,用于其它计算引擎的外部表查询)。 文件众多,会有小文件管理问题,所以建议使用至少需要有spark3环境。 构建 Hudi的meta data使用hfile格式,存储文件信息,避免遍历obs的消耗。问题是源码使用2.4.9版本的hbase,默认基于hadoop2.x版本,如果使用hudi-bundle.jar在hadoop3.x环境运行,会报意向不到的一些异常,例如类文件找不到。 Caused by: java.lang.NoSuchMethodError: org.apache.hadoop.hdfs.client.HdfsDataInputStream.getReadStatistics()Lorg/apache/hadoop/hdfs/DFSInputStream$ReadStatistics; 解决办法是自己编译hbase2.4.9,指定hadoop.profile=3,再编译hudi。 注意,hbase有一些坑,windows环境很多命令不支持,不安装相应shell命令的情况下,可以注释无用的一些exec-maven-plugin,主要是用来做校验之类的工作。 hudi编译 参考资料: HUDI-META-HBASE ISSUE

Written by allen

Attic 在wikipedia中译为“阁楼”。 近两年进入attic的apache项目有不少:sqoop,ambri… 什么时候项目会进入attic? PMC决定不在维护了,或者ASF建议PMC将项目移进attic。 新技术不断涌现,替代者的出现是这些项目逐渐成为历史的直接原因。例如sqoop被datax、flink或spark(seatunnel)数据集成平台、kafka connect所替代。 结语 花无百日红,软件项目的生命周期也一样。优胜劣汰,自然社会进化的亘古不变的规律。

Written by allen

作者:徐志摩 假如我是一朵雪花, 翩翩的在半空里潇洒, 我一定认清我的方向 飞扬,飞扬,飞扬, 这地面上有我的方向。 不去那冷寞的幽谷, 不去那凄凉的山麓, 也不上荒街去惆怅 飞扬,飞扬,飞扬, 你看,我有我的方向! 在半空里娟娟的飞舞, 认明了那清幽的住处, 等着她来花园里探望 飞扬,飞扬,飞扬, 啊,她身上有朱砂梅的清香! 那时我凭籍我的身轻, 盈盈的,沾住了她的衣襟, 贴近她柔波似的心胸 消溶,消溶,消溶 溶入了她柔波似的心胸! 读工大的微信公众号信息《假如我是一朵雪花*》有感 Allen,2022年春,厦门。

Written by allen

自古以来,帝王多疑,而且亲信身边的人。 兼听则明,偏听则暗。 在企业内,亦是如此。 孰是孰非,难有一个标准。 人的想法,部份来自身边人。 春秋战国,臣子大家养了数千门客,想要多一些能人志士出谋划策。 由上而下,少有真才实干的人,容易出现墙头草的情况。容易改变自己的立场,缺乏独立思考和决断的能力或者被迫改变。一言谈的居多,埋没人才。

Written by allen

The Youth’s Companion, Feb.7 1889, p.73(Vol 62) JUST THE BOY WANTED, II IN THE LAW, by Judge Oliver Wendell Holmes (from Howe, Mark DeWolfe. Research materials relating to life of Oliver Wendell Holmes.) A boy who wants to succeed in the law will probably do so. An encouraging thought, as far as it goes. But […]

Written by allen

Source Link: https://www.happierhuman.com/live-consciously/ There are generally two groups of people as far as awareness is concerned. Those that are wired to think before acting… and those who inherently act impulsively. Pausing to collect your thoughts, and considering the consequences of your actions, are habits of conscious people. As you may imagine, there’s much more depth to practicing conscious living, and […]

Written by allen

做YARN做了N年了,也想着存算分离吧?关于HDFS的存储有联邦存储和异构存储策略等内容,存算分离又算一个。存算分离,活生生的例子是KAFKA与PULSA的变化。KAFKA历史悠久,体量大的公司要替换很难,另辟蹊径的是,使用不同服务使其兼容kafka的rpc协议。协议一直是这个问题的根源,要实现存算分离,就要实现相应服务的协议,S3由于体量巨大,一直都是协议标准之一,所以首当其冲。 数据湖,一般结合现有的object store服务,提供基础的存储服务。同理,对于CK等服务,在OSS上实现相应的协议GATEWAY即可替换CK的本地存储,如MINIO。 存算分离有没有性能问题?一方面比较考验的是网络IO,所以局域网需要有理想的网络环境,例如50GB以上带宽。另一方面性能很受本地服务的缓存机制的影响,是否每次请求都重新从OSS拉取一遍数据。对于数据服务类的情况。例如一次查询10GB级的大表,网络不好的话,带宽占用、网络抖动等问题就会出现,所以本地磁盘优先原则依然是适用。 存储操作本质上可以分为两大类:一个operation就是一个对象全量的操作,类似对象存储的put。另一个是append log,不断追加:可以像kafka一样append本地log,也可以用bookeeper做分布式log。 后续一起看看存储相关的底层原理:TODO

Written by allen

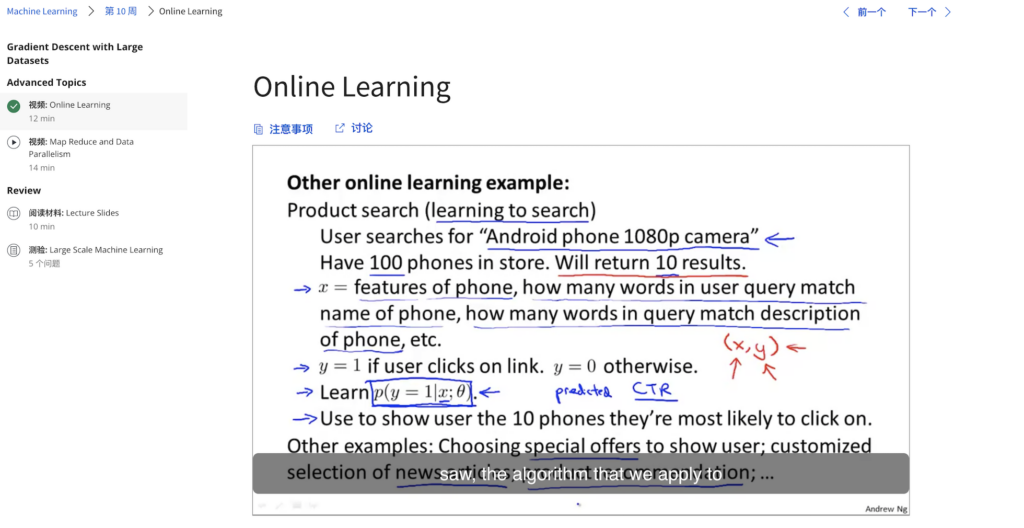

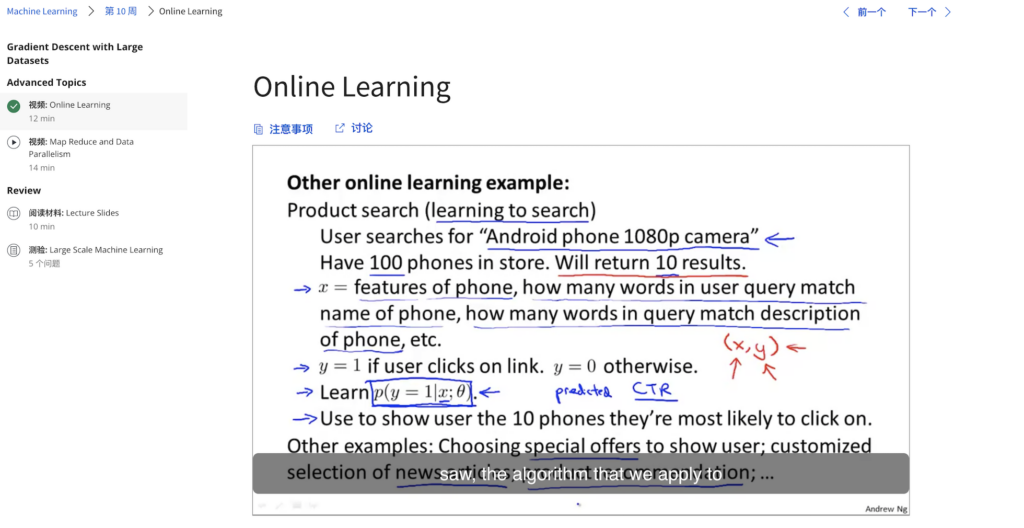

deep learning course @ stanford: https://www.youtube.com/watch?v=PySo_6S4ZAg ml course by Andrew Ng: https://www.youtube.com/watch?v=PySo_6S4ZAg Both are for free, just enjoy it and take your time…

Written by allen

No Comments

Leave a comment Cancel